– Quelle note globale donnez-vous à la formation ? 4,8/5.

– C’est bon, je suis une excellente formatrice, et cette formation était excellente.

Mais est-ce que c’est vraiment vrai ? Est-ce que le fait que les stagiaires aient bien aimé ma formation suffit à ce que ma formation ait été efficace ? Évidemment, la réponse est : ça n’est pas si évident que ça, sinon je ne poserai pas la question !

Voyons donc quelques pistes pour améliorer l’efficacité des formations de formateur·trice.

Une anecdote personnelle

Depuis quelques années, je travaille avec deux collègues sur un projet de livre de remise à niveau en mathématiques pour les sciences. Depuis 2 ans, je fais un échange avec des jeunes : cours gratuit de maths, en échange de la relecture des chapitres du livre en cours de rédaction.

Ce qui marche bien : le feedback immédiat

Grâce à ces séances où les jeunes lisent à voix haute le livre, répondent aux questions posées, et à celles que j’ajoute à la volée, on améliore énormément le livre. Cette rétroaction immédiate me permet d’améliorer nos explications, la mise en page et plein de petites choses.

Ce qui marche moins bien : ce sur quoi je n’ai pas de feedback immédiat

Mais ces séances sont-elles efficaces pour les jeunes ? D’un côté oui, je les vois vraiment progresser dans leur compréhension et dans le capacité de réaliser les exercices posés. Mais est-ce qu’ils progressent pour leurs évaluations au lycée ? Là, c’est moins clair.

On a fait une douzaine de séances avec un jeune sur le livre cette année. Il m’a fallu assez longtemps pour réaliser que ses progrès en séance ne lui permettait pas de rattraper en cours. En effet, il avait beaucoup de retard et surtout, de très mauvaises méthodes de travail à la maison. Si l’objectif était d’abord qu’il améliore sa moyenne (et ce n’était pas l’objectif principal), alors ces séances ne sont pas très efficaces. Si je veux m’améliorer comme enseignante pour l’accompagner à mieux travailler chez lui, il faut que je développe d’autres gestes professionnels (questionner comment il travaille à la maison, développer sa motivation à travailler à la maison (sentiment de compétence, motivation intrinsèque), etc).

La difficulté, c’est que la rétroaction pour ces gestes professionnels ne sera pas rapide. Comme je ne saurais pas rapidement si ce que je fais est efficace, je vais mettre du temps à m’adapter toute seule. Je progresserai plus vite si je lis des travaux d’expert·es, si je vais en formation ou encore mieux, si je suis observée par un·e expert·e !

Cette anecdote illustre : l’importance de la rétroaction sur les bons indicateurs quand on veut savoir si on est efficace.

Je vous propose maintenant de regarder avec ces lunettes une différence assez importante entre le métier d’enseignant·e et celui de formateur·trice d’adultes.

Une différence entre les métiers d’enseignant·e et de formateur·trice

Quand on enseigne en formation initiale

En formation initiale, on a les élèves ou les étudiant·es devant nous pendant une période assez longue pour qu’iels progressent, et nous aussi. On a un feedback immédiat sur ce qui passe et ce qui ne passe pas. Ainsi, on peut « naturellement » s’améliorer, au moins dans nos explications.

Mais, vous savez comme moi que, malheureusement, ça ne marche pas pour toustes les enseignant·es. Il y a au moins deux explications :

- Normalement, quand les élèves sont en échec sur une tâche ou sur une question, l’enseignant·e s’adapte en changeant sa façon d’expliquer ou les activités proposées aux élèves. Mais parfois aussi, l’enseignant·e s’adapte en changeant le thermomètre au lieu de changer la manière d’enseigner. C’est ce qu’on observe dans des classes avec des élèves très faibles et dont les enseignant·es se sont adapté·es en posant des questions qui demandent juste de se souvenir de ce qui a été dit un peu avant 😔.

- L’autre risque, c’est de se mettre en autopilote au bout d’un certain temps quand on pense qu’on a assez progressé. C’est ce que Anders Ericson et Robert Pool rappellent dans leur livre sur l’expertise1. Ainsi, le niveau d’expertise des professionnel·les augmente en général lors de leurs premières années d’exercice, mais décroit lentement ensuite, une fois qu’iels sont en mode « auto-pilote ». Ce n’est évidemment pas vrai de toustes, mais c’est la tendance dominante 😬.

C’est pour ces raisons qu’il est toujours très utile d’aller en formation et/ou d’avoir la chance de pouvoir être observée par quelqu’un qui pourra nous faire des feedbacks pertinents.

Quand on devient formateur·trice

Les choses changent quand on devient formateur ou formatrice d’enseignant·es. L’objectif n’est plus seulement que les apprenant·es comprennent et sachent faire. Il faut aussi que leur comportement change quand ils et elles retourneront enseigner. Et ça n’est pas tout, il faut que cette nouvelle manière de faire aide leurs élèves à mieux apprendre.

L’évaluation des formations selon Kirkpatrick

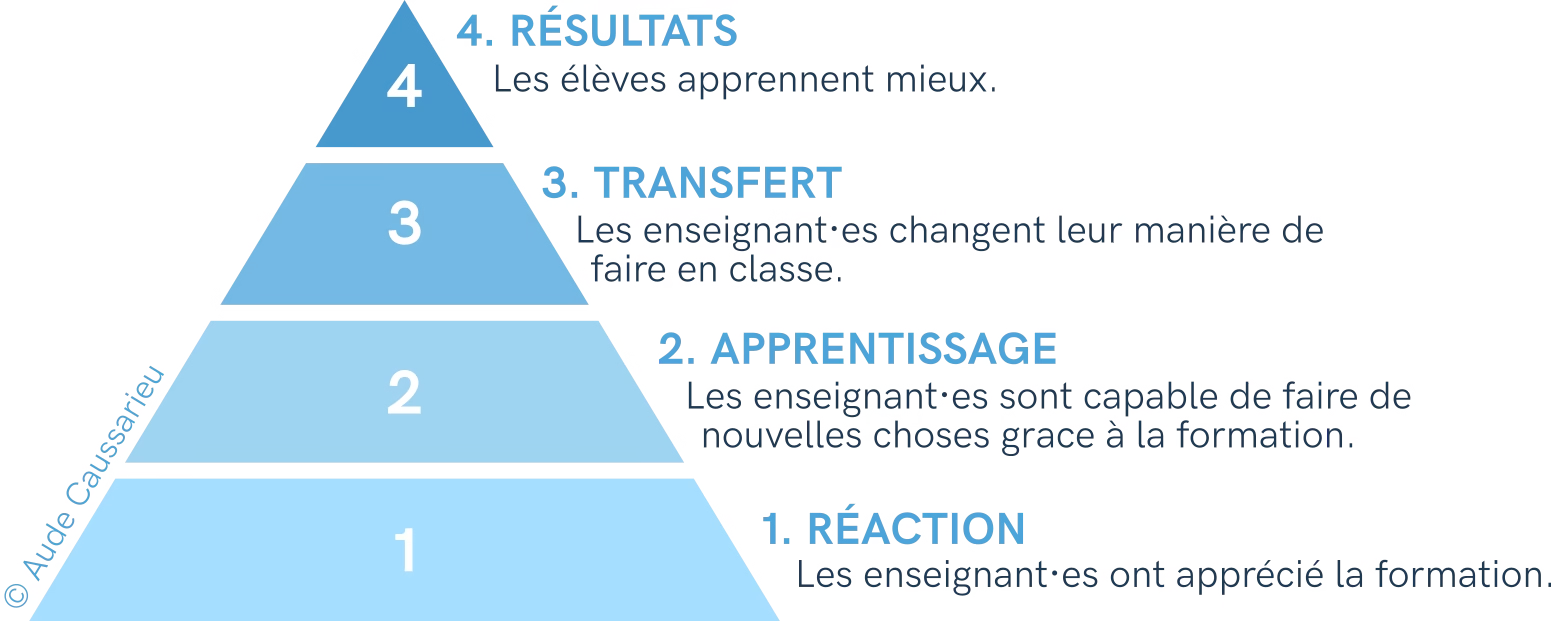

En effet, Kirkpatrick3 explicite quatre niveaux auxquels on peut mesurer l’efficacité d’une formation professionnelle. Cette classification peut évidemment se transposer à la formation d’enseignant·es. C’est ce que j’ai fait dans le schéma ci-dessous.

Des bonnes notes lors de l’évaluation des formations

En formation, on a accès aux réactions des enseignant·es pendant la formation et lors de l’évaluation de la formation. On apprend donc rapidement à ce que nos formations soient appréciées des enseignant·es qui les suivent.

Ainsi, on rencontre rarement des formateurs·trices expérimenté·es dont les formations ne sont pas appréciées par les stagiaires. Et c’est une bonne nouvelle !

Mais peu de formations vraiment efficaces

Malheureusement, les travaux sur l’évaluation des formations montrent que si les participant·es n’ont pas apprécié la formation, les performances seront mauvaises sur les niveaux supérieurs de la pyramide (apprentissage, transfert, résultat). C’est ce à quoi on s’attend.

Mais si les participant·es ont apprécié la formation, ça ne dit PAS que les performances seront bonnes. Il n’y a pas de corrélation entre la satisfaction des apprenant·es et les niveaux supérieurs de la pyramide 😔. Dit autrement, il y a plein de formations qui sont très appréciées par les participant·es mais où iels n’apprennent pas beaucoup de choses et ne changent pas leur manière de faire une fois revenu·es dans leurs lieux de travail 😔.

Et malheureusement, c’est bien ce qu’on observe sur le terrain quand on voit des enseignant·es en classe qui ont suivi nos formations. On se rend compte alors compte du grand écart entre ce le programme de la formation, et ce qui est réellement transféré en classe 😔.

Nos formations sont souvent moins efficaces que ce qu'en disent les apprenant·es 😔.

Comment avoir du feedback sur ce qui compte ?

Il y a plusieurs leviers pour améliorer l’efficacité des formations que l’on anime. L’un de ces leviers, c’est évidemment d’aller soi-même en formation pour apprendre les gestes professionnels qui ont fait leurs preuves dans des études scientifiques. Dans ces formations, on apprend en général qu’une grande partie de l’efficacité de la formation se fait grâce à l’analyse du besoin en amont de la formation.

- Identifier un problème concret que la formation contribuera à résoudre, et donc définir la finalité de la formation.

→ Lien vers un article de ce blog dédié à cette étape de l’analyse du besoin. - Caractériser le comportement qui va contribuer à résoudre le problème, et donc définir l’objectif général de la formation.

- Identifier les freins qui font que ce comportement n’est pas réalisé aujourd’hui, et définir les objectifs intermédiaires de la formation

Mais il y a aussi une stratégie complémentaire : obtenir du feedback sur les niveaux supérieurs de la pyramide de Kirkpatrick. Voici plusieurs leviers que j’utilise régulièrement.

1. Faire pratiquer dans les conditions les plus proches du métier pendant la formation

La première stratégie est de faire pratiquer les savoir-faire que je vise pendant la formation.

Par exemple, dans ma formation sur les mathématiques dans les cours de sciences, on aborde comment corriger un exercice avec du calcul littéral au tableau. Pendant la formation, je vais donc réserver un vrai temps pour que quelques participant·es jouent une correction au tableau. Avec le reste des stagiaires on joue nous le rôle des étudiant·es. La première fois que j’ai fait cette activité, les prestations étaient très éloignées de ce que je pensais avoir expliqué. J’avais pris pour acquis un certain nombre de savoir-faire (tenue du tableau, interaction avec les étudiant·es, etc) qui n’étaient pas maîtrisés par l’ensemble des stagiaires. Ce feedback a été crucial pour que je puisse améliorer la formation.

L’intérêt de cette approche par le jeu de rôle est qu’on voit tout le comportement et que c’est extrêmement instructif. L’un des inconvénients est qu’on ne voit que les 2 ou 3 personnes qui passent devant tout le monde. L’autre approche que j’utilise est d’utiliser des petites scénettes que j’ai conçues en amont, avec plusieurs options d’actions possibles. C’est un peu comme un jeu dont vous êtes le héros. Je cible alors les éléments de comportement que je veux observer. Je vois moins de choses, mais j’ai un feedback pour chaque participant·e et je peux alors m’assurer que les stagiaires maîtrisent au moins une partie du savoir-faire visé dans la formation.

2. Utiliser l’évaluation des formations à froid pour avoir du feedback

Ma deuxième stratégie est d’utiliser l’évaluation à froid de la formation pour récupérer du feedback sur ce qui a été transféré, ou pas, dans la classe. Il y a deux questions que j’aime bien poser dans ces évaluations :

1. Qu'est-ce qui a changé dans votre pratique depuis que vous avez suivi la formation #Bidule ? 2. Qu'est-ce que vous auriez aimé changer d'autres après la formation ? Qu'est-ce qui aurait rendu ce changement possible ou plus facile ?

La difficulté est d’avoir des réponses quelques mois après la formation. Je trouve que j’ai un petit peu plus de réponses quand j’écris personnellement à chaque personne. Je peux alors ajouter quelques éléments de contexte (« et dans ton cours de mécanique, tu as pu essayer cette stratégie dont on avait parlé ? »).

3. Utiliser une évaluation à chaud qui porte sur des éléments corrélés au transfert

Je rédige une enquête d’évaluation à chaud qui porte sur ce qui corrèle vraiment au transfert :

- L’efficacité globale :

- Si je dois faire un QCM, je pose une question (en suivant les préco de Will Thalheimer) dont l’objectif est de répondre à la question : êtes vous capable (et avez vous envie) de mettre en pratique ce qu’on vient de voir en formation ?

- Si je peux poser des questions ouvertes, je demande :

Qu'allez-vous changer dans votre pratique après cette formation ?

- Les facteurs liés au transfert :

- La compréhension

- La mémorisation

- La motivation

- Et le suivi de la formation.

J’ai détaillé cette stratégie dans l’article sur le livre de Will Thalheimer : Performance Focused learner surveys.

Références pour aller plus loin

- Peak : Secrets from the new science of expertise de Anders Ericsson et Robert Pool. Les auteurs analysent la trajectoire d’expert·es de tous domaines : échecs, musique, sport, mathématiques, …

- >Système 1 / Système 2 : les deux vitesses de la pensée du prix Nobel d’économie Daniel Kahneman. Le chapitre 22 porte sur l’intuition des expert·es.

- Le livre de Kirkpatrick : Evaluating Training Programs : The Four Levels (1998).

- L’article sur le livre de Will Thalheimer : Performance Focused learner surveys.

- Lien vers les articles sur l’analyse du besoin sur ce blog.